Es claro que hay un gran temor por parte de los medios masivos de comunicación debido al despertar en masa de la población. Las redes sociales, que en un principio fueron una herramienta más en su plan de control, han sido utilizadas por el público como un arma para buscar la verdad y tratar de hacer que otras personas empiecen a ver que hay mucho más detrás de lo que los medios masivos nos quieren hacer creer.

El juego es claro, los medios masivos son el brazo de propaganda de las entidades que quieren controlar la opinión de la población y quieren evitar a toda costa que la gente, en sus propios términos, llegue a descubrir la verdad que se nos ha ocultado durante siglos.

El siguiente artículo, escrito por Jack Nicas, con la producción de Ramsey Taylor, Alana Celii y David Horn y publicado el 2 de marzo del 2020 en el New York Times, nos deja muy en claro que, tanto ellos, los medios masivos, como la inmensa plataforma de videos YouTube (y sus controladores), están totalmente en pánico por el despertar masivo del público, porque ven que la gente ya no les cree, y en su desesperación por «corregir nuestra opinión» a su antojo, nos revelan claramente cuál es su plan y su nivel de pánico.

¿Puede YouTube callar a sus teóricos de la conspiración?

Un nuevo estudio examina los esfuerzos de YouTube para limitar la difusión de las teorías de conspiración en su sitio, desde videos que afirman que los tiempos finales están cerca hasta aquellos que cuestionan el cambio climático.

Por Jack Nicas

Producido por Rumsey Taylor, Alana Celii y Dave Horn

2 de marzo del 2020

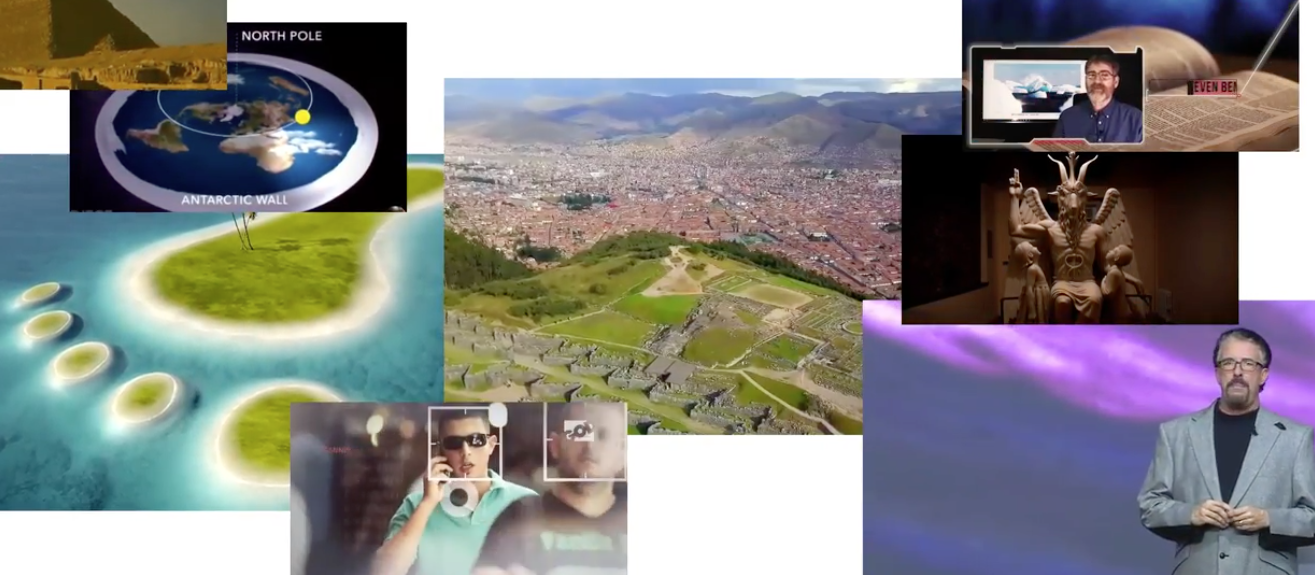

El cambio climático es un engaño, la Biblia predijo la elección del presidente Trump y Elon Musk es un adorador del diablo que intenta dominar el mundo.

Todas estas ficciones han encontrado vida en YouTube, el sitio de videos más grande del mundo, en parte porque las propias recomendaciones de YouTube dirigieron a las personas hacia ellos.

Durante años esto ha sido un megáfono altamente efectivo para los teóricos de la conspiración, y YouTube, propiedad y administrado por Google, lo ha admitido. En enero del 2019, YouTube dijo que limitaría la difusión de videos «que podrían desinformar a los usuarios de manera nociva».

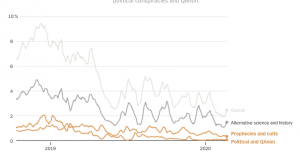

Un año después, YouTube recomienda teorías de conspiración mucho menos que antes. Pero su progreso ha sido desigual y continúa apoyando ciertos tipos de inventos, según un nuevo estudio de investigadores de la Universidad de California, Berkeley.

Los esfuerzos de YouTube para frenar las teorías de conspiración plantean una prueba importante de la capacidad de Silicon Valley para combatir la información errónea, particularmente antes de las elecciones de este año. El estudio, que examinó ocho millones de recomendaciones durante 15 meses, proporciona una de las imágenes más claras hasta la fecha de esa pelea, y los resultados mixtos muestran cuán desafiante sigue siendo el problema para las compañías tecnológicas como Google, Facebook y Twitter.

Los investigadores descubrieron que YouTube casi ha erradicado algunas teorías de conspiración de sus recomendaciones, incluidas las afirmaciones de que la tierra es plana y que el gobierno de EE. UU. llevó a cabo los ataques terroristas del 11 de septiembre, dos falsedades que la compañía identificó como objetivos el año pasado. En junio, YouTube dijo que la cantidad de tiempo que las personas pasaban viendo tales videos de sus recomendaciones se había reducido en un 50 por ciento.

Sin embargo, los investigadores de Berkeley descubrieron que justo después de que YouTube anunciara ese éxito, sus recomendaciones de teorías de conspiración volvieron a subir y luego fluctuaron en los siguientes meses.

***Esta es la parte de los videos de conspiración recomendados de los principales clips relacionados con noticias

Los datos también mostraron que otras falsedades continuaron floreciendo en las recomendaciones de YouTube, como las afirmaciones de que los extraterrestres crearon las pirámides, que el gobierno está ocultando tecnologías secretas y que el cambio climático es una mentira.

Los investigadores sostienen que esos hallazgos sugieren que YouTube ha decidido qué tipos de información errónea quiere eliminar y qué tipos está dispuesto a permitir. «Es un problema tecnológico, pero al final del día también es un problema de política», dijo Hany Farid, profesor de ciencias de la computación en la Universidad de California, Berkeley, y coautor del estudio.

«Si tienes la capacidad de reducir esencialmente parte del contenido particularmente problemático cerca de cero, entonces puedes hacer más en muchas cosas», agregó. «Usan la palabra «no puedo» cuando quieren decir «no quiero”.

Farshad Shadloo, un portavoz de YouTube, dijo que las recomendaciones de la compañía apuntaban a dirigir a las personas hacia videos autorizados que los dejaran satisfechos. Dijo que la compañía estaba mejorando continuamente el algoritmo que genera las recomendaciones. «Solo durante el año pasado, hemos lanzado más de 30 cambios diferentes para reducir las recomendaciones de “contenido límite” y la información errónea dañina, incluida la información errónea sobre el cambio climático y otros tipos de videos de conspiración», dijo. «Gracias a ese cambio, el tiempo de reproducción que ese tipo de contenido obtiene de las recomendaciones se ha reducido en más del 70 por ciento en los Estados Unidos».

El poderoso algoritmo de recomendación de YouTube, que empuja a sus dos mil millones de usuarios mensuales a videos que cree que verán, ha impulsado el ascenso de la plataforma para convertirse en la nueva televisión para muchos en todo el mundo. La compañía ha dicho que sus recomendaciones generan más del 70 por ciento de las más de mil millones de horas que las personas pasan viendo videos cada día, convirtiendo al software que selecciona las recomendaciones en uno de los algoritmos más influyentes del mundo.

El éxito de YouTube ha llegado con un lado oscuro. La investigación ha demostrado que las recomendaciones del sitio han ampliado sistemáticamente videos divisivos, sensacionalistas y claramente falsos. Otros algoritmos destinados a captar la atención de las personas para mostrarles más anuncios, como las noticias de Facebook, han tenido el mismo problema.

Hay mucho en juego. YouTube se enfrenta a una avalancha de información errónea y contenido desagradable cargado diariamente. El F.B.I. recientemente identificó la difusión de teorías de conspiración marginal como una amenaza terrorista doméstica.

El mes pasado, un hombre alemán cargó un discurso a YouTube diciendo que las «sociedades secretas invisibles» usan control mental para abusar de los niños en bunkers subterráneos. Más tarde disparó y mató a nueve personas en un suburbio de Frankfurt.

Para estudiar YouTube, Farid y otro investigador de Berkeley, Marc Faddoul, se unieron a Guillaume Chaslot, un ex ingeniero de Google que ayudó a desarrollar el motor de recomendación y ahora lo estudia.

Desde octubre del 2018, los investigadores han recopilado recomendaciones que aparecieron junto a videos de más de 1,000 de los canales más populares y relacionados con noticias, recomendados de YouTube, haciendo de su estudio uno de los exámenes más extensos y detallados del tema. Luego entrenaron un algoritmo para calificar, en una escala de 0 a 1, la probabilidad de que un video dado promoviera una teoría de conspiración, incluso analizando sus comentarios, transcripción y descripción.

Aquí hay seis de los videos más recomendados sobre política en el estudio.

«La presidencia de Trump: proyecciones y patrones proféticos»

«Este es el juego final! ¡Trump es parte de su plan! La tormenta está llegando 2019-2020 «

«Lo que se supone que no debes saber sobre la fundación de Estados Unidos»

“Rosa Koire. Agenda 2030 de la ONU expuesta ”

«Predicciones del estado profundo 2019: volcado de datos importantes con DAVID WILCOCK [Parte 1]»

«David Icke discute teorías y políticas con Eamonn Holmes»

Como la mayoría de los intentos de estudiar YouTube, el enfoque tiene fallas. Determinar qué videos impulsan las teorías de conspiración es subjetivo, y dejarlo en manos de un algoritmo puede conducir a errores.

Para tener en cuenta los errores, los investigadores incluyeron en su estudio solo videos que obtuvieron puntajes superiores a 0.5 en la escala de probabilidad. También descartaron muchos videos en función de su calificación: los videos con una calificación de 0.75, por ejemplo, valían tres cuartos de una recomendación de teoría de conspiración en el estudio.

Las recomendaciones también se recopilaron sin iniciar sesión en una cuenta de YouTube, lo cual no es la forma en que la mayoría de la gente usa el sitio. Al iniciar una sesión, las recomendaciones se personalizan según el historial de visualización de las personas. Pero los investigadores no han podido recrear recomendaciones personalizadas a escala, y como resultado han tenido problemas para estudiarlas.

Ese desafío ha disuadido otros estudios. Arvind Narayanan, profesor de informática en la Universidad de Princeton, dijo que él y sus estudiantes abandonaron la investigación sobre si YouTube podría radicalizar a los usuarios porque no podían examinar recomendaciones personalizadas. A fines del año pasado, Narayanan criticó un estudio similar, el cual concluyó que YouTube difícilmente radicalizaba a sus usuarios, porque solo estudiaba las recomendaciones sin inicio de sesión, entre otras cuestiones.

Narayanan revisó el estudio de Berkeley a pedido del New York Times y dijo que era válido estudiar la tasa de recomendaciones de la teoría de conspiración a lo largo del tiempo, incluso cuando no se haya iniciado una sesión. Pero sin examinar las recomendaciones personalizadas, dijo, el estudio no podría ofrecer conclusiones sobre el impacto en los usuarios.

«Para mí, una pregunta más interesante es: ‘¿Qué efecto tiene la promoción de los videos de conspiración a través de YouTube en las personas y la sociedad?’”, Dijo Narayanan en un correo electrónico. «No tenemos buenas formas de estudiar esa pregunta sin la cooperación de YouTube».

El Sr. Shadloo, de YouTube, cuestionó los hallazgos del estudio porque la investigación se centró en las recomendaciones sin inicio de sesión, lo cual, reiteró no representa la experiencia de la mayoría de las personas. También dijo que la lista de canales que el estudio utilizó para recopilar recomendaciones era subjetiva y no representaba lo que es popular en el sitio. Los investigadores dijeron que eligieron los canales relacionados con noticias más populares y recomendados.

El estudio destaca un popurrí de paranoia y engaño. Algunos videos afirman que los ángeles están ocultos debajo del hielo en la Antártida (1.3 millones de visitas); que el gobierno está ocultando tecnologías como la levitación y la electricidad inalámbrica (5,5 millones de visitas); que un video de dignatarios que reaccionan ante algo en el funeral de George Bush confirma que se avecina una gran revelación (1.3 millones de visitas); y que las fotos del rover de Marte prueban que hubo una civilización en el planeta (850,000 vistas).

Aquí hay seis de los videos más recomendados sobre fenómenos sobrenaturales en el estudio.

«Por qué la NASA nunca volvió a la luna …»

«ESTO ACABA DE OCURRIR EN RUSIA, PERO ALGO MAS RARO ESTÁ PASANDO EN EL MONTE SΙNΑI»

«Nikola Tesla – Energía ilimitada y las pirámides de Egipto»

«Si esto no te hace un creyente, dudo que algo lo haga»

«La revelación de las pirámides (documental)»

«Los científicos de tecnologías más antiguas aún no pueden explicar»

A menudo, los videos tienen publicidad, lo que ayuda a financiar la próxima producción de los creadores. YouTube también recibe una parte.

Algunos tipos de teorías de conspiración fueron recomendados cada vez menos en el 2019, incluidos videos con profecías del fin del mundo.

Un video visto 600,000 veces y titulado «¿Podría Emmanuel Macron ser el Anticristo?» afirmó que había señales de que el presidente francés era el diablo y que el final del tiempo estaba cerca. (Algunas de sus pruebas: obtuvo el 66.06 por ciento de votos).

En diciembre del 2018 y enero del 2019, el estudio encontró que YouTube recomendó el video 764 veces en la lista de recomendaciones “Siguiente” que aparece junto a los videos analizados en el estudio. Luego las recomendaciones se detuvieron abruptamente.

Los videos que promocionan a QAnon, la teoría de la conspiración pro-Trump que afirma que los pedófilos del «estado profundo» controlan el país, tenían miles de recomendaciones a principios del 2019, según el estudio. Durante el año pasado, YouTube recortó bruscamente las recomendaciones de los videos de QAnon, según muestran los resultados, en parte, aparentemente, al evitar a algunos canales que impulsan la teoría.

Esta es la parte de recomendaciones de diferentes tipos de conspiraciones

La mayoría de los videos de teoría de la conspiración recomendados fueron etiquetados en una de tres categorías: ciencia alternativa e historia; profecías y cultos en línea; y conspiraciones políticas y QAnon.

Si bien YouTube recomienda menos esos videos, todavía aloja muchos de ellos en su sitio. Para algunos temas como el alunizaje y el cambio climático, ahora YouTube apunta a socavar las afirmaciones desacreditadas al incluir enlaces de Wikipedia debajo de los videos.

Un video de Fox News titulado «La verdad sobre el calentamiento global», el cual se recomendó 15.240 veces en el estudio, ilustra el desafío de YouTube en la lucha contra la información errónea. YouTube ha dicho que ha tratado de dirigir a las personas hacia una mejor información confiando más en los canales masivos, pero a veces esos canales publican puntos de vista desacreditados. Y algunos videos no siempre son teorías conspirativas claras.

En el video de Fox News, Patrick Michaels, un científico financiado en parte por la industria de los combustibles fósiles, dijo que el cambio climático no era una amenaza porque los pronósticos del gobierno son sistemáticamente defectuosos y exageran el riesgo.

Varios científicos disputan las opiniones del Sr. Michaels y señalan datos que muestran que los pronósticos han sido precisos.

Michaels «realmente califica como teórico de la conspiración», dijo Andrew Dessler, un científico del clima de la Universidad de Texas A&M. «La clave no es solo que su ciencia está equivocada, sino que la empaqueta con acusaciones de que la ciencia climática es corrupta».

«Todo lo que dije en el video es un hecho, no una cuestión de opinión», respondió el Sr. Michaels. «La verdad es muy inconveniente para los activistas climáticos».

Sin embargo, muchas de las teorías de conspiración que YouTube sigue recomendando provienen de canales marginales.

Considera a Perry Stone, un televangelista que predica que los patrones en la Biblia pueden predecir el futuro, que el cambio climático no es una amenaza y que los líderes mundiales adoran al diablo. Las recomendaciones de YouTube de sus videos han aumentado constantemente, dirigiendo a la gente hacia él casi 8,000 veces en el estudio. Muchos de sus videos ahora recopilan cientos de miles de visitas cada uno.

«Me divierte que algunos de los investigadores de la academia no religiosa consideren partes de mi enseñanza que vinculan las profecías bíblicas y su cumplimiento en la actualidad, como una mezcla de teorías de conspiración extravagantes», dijo Stone en un correo electrónico. El cambio climático, dijo, simplemente había sido renombrado: «Los hombres han sobrevivido al diluvio de Noé, la destrucción de Sodoma, el volcán de Pompeya».

En cuanto a la afirmación de que los líderes mundiales son «luciferinos», la información «me la dio directamente un multimillonario europeo», dijo. «No divulgaré su información ni su identidad».

Fuente (en inglés):

https://www.nytimes.com/interactive/2020/03/02/technology/youtube-conspiracy-theory.html

Las personas con criterio formado y cultura normal donde sostiene y afirma que las matemáticas son claras no tendrán los problemas que se mencionan y un papel fundamental en esto es el libre AlBEDRIO de las personas que los medios masivos no le han dado la importancia y que juega un papel primordial en lo que se pueda discutir o decidir así de simple y claro es la palabra Libre Albedrío

Pues así ellos traten de sensurar ya se les salió de las manos, y no pueden haser nada, nos dieron la tecnología, y ahora se vuelve contra ellos la gente está despertando. Gracias❤️

Yo tengo dentro del YouTube, unos 100 canales vinculados al misterio, historia antigua, etc,,,.

Antiguamente reproducía un vídeo, y cuando este terminaba, el buscador de YouTube, me reproducía otro vídeo nuevo DENTRO DE MIS SUSCRIPCIONES, y de esa manera, iba viendo las novedades de los canales suscriptores.

Desde hace meses, ya no me reproduce automáticamente, mis canales, si no, q ME OBLIGA VER CANALES A LOS Q NO ESTOY SUSCRITO, con un contenido TOTALMENTE CONTRARIO AL PENSAMIENTO de mis canales suscritos.

Para ser concretos, el canal q YouTube quiera q vea a destapo, y se puede pegar horas pasando documentales de dicho canal es , DW, un canal de índole documentalista. ( No tengo nada contra ese canal, pero NO ES DE MI AGRADO, y YOUTUBE ME LO PONE A DIESTRO Y SINIESTRO)